NotebookLM es la herramienta de Google basada en inteligencia artificial diseñada para ayudarte a organizar, sintetizar y comprender información de múltiples fuentes. Se ha convertido en mucho más que un bloc de notas inteligente, ya que ahora puede generar vídeos, analizar imágenes, leer hojas de cálculo, realizar investigaciones profundas y crear tarjetas de repaso. Todo desde una misma interfaz.

En este artículo repaso lo más relevante y te doy ejemplos tanto para el ámbito educativo como para usuarios que simplemente quieren organizar mejor su conocimiento, estudiar o investigar.

Tal y como compartió Juan Vicente García Manjón, NotebookLM permite ya describir con tus propias palabras el estilo visual del vídeo que quieres generar: desde los colores, hasta la tipografía, pasando por la narrativa y el tono.

También puedes definir el guion y el enfoque temático de la narración, de forma que el vídeo se adapte completamente al propósito comunicativo que necesitas.

Aplicación educativa: Un profesor puede crear un vídeo para introducir un tema de forma visual, adaptado al nivel del alumnado y coherente con su enfoque didáctico.

Aplicación general: Un profesional puede generar presentaciones visuales personalizadas para explicar un proyecto o compartir conocimiento sin depender de editores de vídeo.

NotebookLM estrena un modo de investigación profunda que explora cientos de sitios web, selecciona la información más relevante, la organiza en un informe estructurado y añade una lista de fuentes anotadas para que puedas ampliar.

No es un resumen automático. Es un documento con citas, estructura, referencias y contexto, que puedes añadir directamente a tu cuaderno.

Aplicación educativa: Un estudiante puede realizar una búsqueda seria para un trabajo de investigación, obteniendo un marco teórico con enlaces reales y anotaciones útiles.

Aplicación general: Cualquier persona que quiera tomar una decisión informada (por ejemplo, sobre salud, finanzas o tecnología) puede usar esta función como punto de partida fiable.

NotebookLM ya acepta imágenes como fuente. Y no hablamos solo de ilustraciones: puedes subir fotos de apuntes, capturas de pantalla de un libro, esquemas hechos a mano o gráficos de una web. El sistema extrae el contenido, lo analiza y lo convierte en conocimiento estructurado.

Aplicación educativa: Un docente puede escanear la pizarra tras una clase y generar ejercicios a partir de ese material.

Aplicación general: Alguien puede capturar una tabla financiera, una receta o un gráfico técnico, y obtener una explicación generada por IA sin tener que transcribir nada.

Una de las mejoras más prácticas: ahora puedes conectar PDFs y hojas de cálculo de Google Drive directamente como fuentes en NotebookLM. Y si ese documento se actualiza, la IA mantiene la versión sincronizada y genera análisis nuevos automáticamente.

Aplicación educativa: Un equipo docente gestiona una hoja compartida con el calendario de evaluaciones. Cada vez que se actualiza, pueden generar avisos, informes y materiales sin subir un nuevo archivo.

Aplicación general: Alguien que lleva sus gastos mensuales en una hoja de Drive puede conectarla a NotebookLM y recibir resúmenes automáticos actualizados sin repetir el proceso.

Otra mejora que se esperaba: ya puedes cerrar una sesión de NotebookLM y retomarla más tarde sin perder la conversación anterior. Y si el cuaderno está compartido, cada usuario tiene su propio historial de interacción con la IA.

Aplicación educativa: Un alumno empieza una tarea en clase, la interrumpe y puede continuar desde casa retomando exactamente el mismo hilo.

Aplicación general: Alguien que investiga un tema complejo por etapas (como un proyecto laboral o un cambio profesional) puede construir su conocimiento de forma progresiva.

Las tarjetas de repaso y los quizzes ya están completamente disponibles en la app móvil de NotebookLM. Puedes crear, editar y utilizar estos recursos desde el teléfono, lo que facilita el estudio autónomo y la autoevaluación continua.

Aplicación educativa: Un grupo de estudiantes genera una batería de preguntas tipo test antes del examen y la usa para practicar en el autobús o en casa.

Aplicación general: Una persona que está aprendiendo un idioma o preparándose una oposición puede repasar cada día desde el móvil sin necesidad de apps externas.

Estas actualizaciones colocan a NotebookLM en una posición única como herramienta de trabajo cognitivo:

Si yo tuviera un hijo en Secundaria, Bachillerato, FP o Universidad, o si estuviera preparando unas oposiciones, no me lo pensaría: NotebookLM sería el asistente personal de estudio.

No porque lo sepa todo (porque no lo sabe), sino porque le ayudaría a organizarse mejor, a entender mejor, a estudiar mejor. De hecho, Sal Khan (fundador de Khan Academy) lo explica con claridad en este vídeo: La IA como tutor personal. Habla del enorme potencial de la inteligencia artificial para mejorar los resultados del alumnado, personalizar el aprendizaje y reducir la desigualdad de acceso a buenos recursos educativos.

Si este artículo te ha servido, compártelo con alguien a quien también pueda ayudarle: un estudiante, un docente, un opositor, o simplemente alguien que quiere aprender mejor.

» www.vicentgadea.com/newsletter «

Durante mis años como directivo he vivido lo mismo que viven hoy cientos de líderes educativos: agendas imposibles, urgencias constantes y una presión diaria que, casi siempre, empuja a renunciar a la propia formación.

Es comprensible: uno sacrifica lo que parece prescindible para atender lo urgente.

Pero en el contexto actual eso supone un riesgo enorme.

Cada vez que un centro organiza una formación sobre Inteligencia Artificial y la dirección no está presente, se pierde algo fundamental: la capacidad de liderar con criterio aquello que se está implantando.

No podemos pedir al profesorado que aplique la IA si nosotros mismos no sabemos valorar su impacto, sus riesgos o su potencial. Y, sobre todo, no podemos liderar lo que no comprendemos (INTEF, 2024).

La IA ya está afectando a la enseñanza, la evaluación, la organización escolar y la gestión interna (UNESCO, 2023b). Por eso, los organismos internacionales coinciden en una idea clara:

“La IA no transforma las escuelas; lo hacen las personas que lideran su integración” (INTEF, 2024).

Implementarla no es instalar herramientas. Es gestionar un cambio profundo (OECD, 2023), que implica ética, gobernanza, formación continua y visión estratégica.

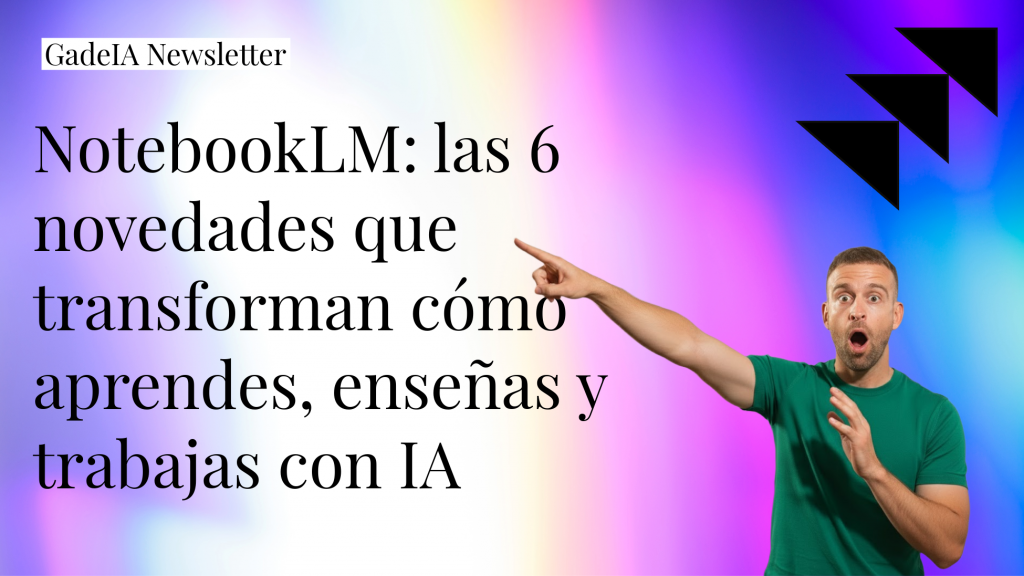

A continuación presento un modelo de 7 pasos, fundamentado en guías oficiales de UNESCO, INTEF, OECD, DESE (Massachusetts) y European Schools, para ayudar a cualquier centro a implantar la IA de forma responsable, sostenible y alineada con los derechos humanos.

Modelo de 7 pasos para la implantación de la IA en el centro educativo (Gadea, 2025)

El proceso no comienza con “qué herramienta usar”, sino con una pregunta más honesta: ¿Dónde está realmente el centro?

El liderazgo debe alejarse del “tecnologicismo” —adoptar tecnología sin propósito educativo— (INTEF, 2024) y analizar tres dimensiones:

Un buen diagnóstico evita errores costosos y permite diseñar una estrategia coherente.

La IA educativa se considera mayoritariamente un sistema de alto riesgo por su potencial impacto en menores, privacidad y equidad (Parlamento Europeo, 2024).

Por ello, cualquier implantación debe basarse en un marco sólido de derechos y garantías.

Sin este marco, ningún centro puede garantizar un uso seguro ni responsable.

Este documento es el pilar central de la estrategia del centro y debe integrarse en el Plan Digital de Centro (INTEF, 2024). Su función es ordenar, proteger y garantizar coherencia.

En otro número de esta newsletter dedicaré un análisis completo a cómo elaborar este documento clave, abordando en profundidad:

Porque un Marco de Uso de la IA bien diseñado no es burocracia: es la brújula que convierte la IA en un recurso seguro, coherente y alineado con los valores del centro. Cabe remarcar que este documento debe revisarse cada año para adaptarse a cambios tecnológicos y regulatorios.

La formación es el motor que hace posible el cambio. Debe ser continua, práctica y ajustada a cada rol (OECD, 2023).

Además, la formación debe tratar los riesgos cognitivos: dependencia tecnológica, reducción del esfuerzo mental o debilitamiento de la metacognición (UNESCO, 2024b).

La implantación debe ser incremental, basada en evidencia y diseñada para aprender (European Commission, 2022). Por ello, los centros deberían comenzar con tres áreas de pilotaje especialmente recomendadas, para explorar beneficios, detectar riesgos y ajustar las prácticas antes de extenderlas al conjunto del centro.

Los pilotos constituyen un entorno seguro donde probar, medir y ajustar. Son la vía más eficaz para generar evidencia real y validar prácticas antes de escalar el modelo a todo el centro.

Una implantación responsable debe basarse en datos y evidencias (UNESCO, 2023b), evaluando de forma sistemática cuatro dimensiones clave:

El objetivo no es controlar, sino mejorar, ajustar y garantizar un uso responsable de la IA.

La implantación de la IA no es un proyecto puntual, sino un proceso continuo que debe consolidarse mediante cuatro ejes estratégicos:

El reto no es “usar IA”, sino integrarla con propósito, ética y visión. Una transformación tecnológica solo es sostenible cuando la dirección se forma, participa y lidera con coherencia.

La IA no sustituirá al liderazgo educativo.

Pero los líderes que comprendan su impacto marcarán el futuro de sus centros.

Si tu centro quiere iniciar este camino de forma estratégica y responsable, puedo acompañaros en el diseño del Marco de Uso, la formación por perfiles y la implantación progresiva de la IA.

👉 Contacto y más información: vicentgadea@outlook.com

AI Pioneers. (2025). Evaluation schema for AI in education on data, privacy, ethics, and EU values. Work Package 5.

European Commission. (2022). Ethical guidelines on the use of artificial intelligence (AI) and data in teaching and learning for educators. Publications Office of the European Union.

European Schools. (2025). Legal and pedagogical guidelines for the educational use of generative artificial intelligence in the European Schools. Schola Europaea / Office of the Secretary-General.

Instituto Nacional de Tecnologías Educativas y de Formación del Profesorado (INTEF). (2024). Guide on the Use of Artificial Intelligence in Education. Spanish Ministry of Education, VET and Sports.

Massachusetts Department of Elementary and Secondary Education (DESE). (2025). Massachusetts guidance for artificial intelligence in K–12 education.

United Nations Educational, Scientific and Cultural Organization (UNESCO). (2019a). Beijing Consensus on Artificial Intelligence and Education.

United Nations Educational, Scientific and Cultural Organization (UNESCO). (2023b). Guidance for generative AI in education and research.

United Nations Educational, Scientific and Cultural Organization (UNESCO). (2025). AI and education: Protecting the rights of learners.

Hace un par de años, cuando empecé a hablar sobre la estructura universal de prompting y sobre la paradoja del “googleizador”, el debate giraba en torno a cómo formular mejor las preguntas a la IA. En aquel momento, parecía que todo dependía del prompt perfecto. Incluso se llegó a hablar de la figura del “ingeniero de prompts”, como si dominar ese arte fuera el gran secreto para obtener buenos resultados.

Hoy la realidad es distinta. No hace falta ser un ingeniero de prompts, pero sí saber utilizarlos bien. El prompting sigue siendo una herramienta útil para acercarte al primer resultado que se parece a lo que buscas. Es una base necesaria, sobre todo para quienes se inician en el uso educativo de la inteligencia artificial.

En las formaciones que imparto —tanto en colegios como en institutos, universidades, sindicatos o consejerías— hay algo que siempre se repite. A casi todos les han hablado de prompting, de cómo escribir una buena instrucción o de cómo aprovechar mejor el “actúa como…”. Pero muy pocos han escuchado hablar de algo todavía más importante: el contexto.

Una y otra vez encuentro el mismo denominador común. Los docentes aprenden a “pedirle cosas” a la IA, pero no a enseñarle a pensar dentro del entorno educativo en el que trabajan. Y ahí está la gran diferencia entre usar una herramienta de moda y aprovecharla de verdad como un copiloto pedagógico.

Por eso sigo convencido de que debemos seguir formando en prompting, sí, pero solo como punto de partida. Es fundamental aprender a comunicarse con la IA con claridad, estructura y propósito.

Sin embargo, lo que realmente marca la diferencia hoy ya no es cómo preguntamos, sino desde dónde preguntamos. Es decir, con qué información, contexto y propósito acompañamos esa instrucción.

Y aquí es donde entra la mirada de David Hurtado y su concepto de ingeniería de contexto, un enfoque que, sinceramente, me ha hecho repensar por completo cómo usamos la IA en educación. Hurtado repite una idea que me parece esencial:

“La IA no falla por tus prompts, falla por tu contexto.”

Durante mucho tiempo los docentes hemos puesto el foco en el formato de la pregunta, en si debíamos escribir “actúa como profesor de…” o “crea una rúbrica de…”. Pero Hurtado nos invita a mirar más allá. No se trata de la forma, sino del terreno sobre el que la IA construye su respuesta. Si el contexto es pobre, desordenado o ambiguo, la respuesta también lo será.

En las últimas semanas he estado revisando con calma los distintos artículos de David Hurtado sobre ingeniería de contexto —desde su defensa del contexto frente al prompt hasta su último post Los seis niveles del contexto de la IA (noviembre de 2025)—, y no exagero al decir que su enfoque puede transformar por completo la manera en que entendemos el uso de la inteligencia artificial en los centros educativos.

Sus ideas conectan profundamente con algo que ya venía observando en mis propias formaciones: la necesidad de que los docentes no se limiten a aprender a pedirle cosas a la IA, sino que aprendan a construir contextos de trabajo inteligentes y éticos.

La ingeniería de contexto va precisamente de eso: de enseñar a la IA a pensar dentro de tu marco educativo. De acompañarla con la información, los procesos y los valores que definen tu manera de enseñar.

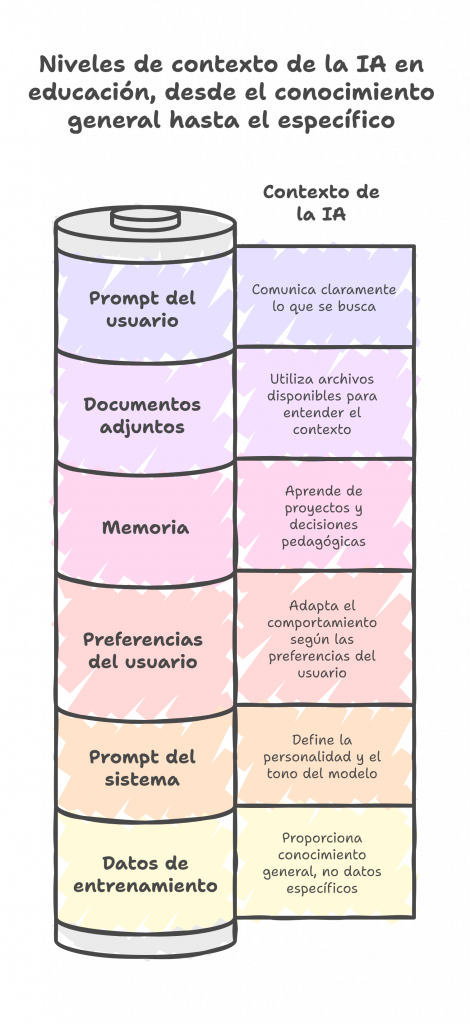

A partir de aquí, quiero compartir cómo se pueden extrapolar los seis niveles de contexto que plantea David Hurtado al ámbito educativo, con ejemplos concretos que muestran cómo cada uno influye en la manera en que trabajamos con la IA en la escuela.

Hurtado explica que los datos de entrenamiento le dan al modelo un conocimiento general del mundo muy potente y patrones de razonamiento interesantes, pero advierte algo esencial:

“Los datos específicos que tiene en su entrenamiento no son fiables. Solo son predicciones. Y dato que no tiene, dato que se puede inventar.”

En educación, esto es clave. ChatGPT conoce teorías pedagógicas, metodologías activas o los ODS, pero no conoce tu centro, tu alumnado ni tus proyectos reales. Si no le das tú ese contexto, se lo inventará.

La primera lección es clara: nunca des por hecho que la IA sabe cómo funciona tu aula. Debes aportarle tú la información educativa y ética que necesita para responder con sentido.

El segundo nivel define el carácter del modelo.

Como explica David Hurtado, “el prompt del sistema es lo que el proveedor del modelo escribió para definir su personalidad, tono y límites.” Es decir, esas instrucciones iniciales determinan si una IA será más formal, más creativa o más conservadora en su forma de razonar.

Por eso ChatGPT puede resultar más conversacional, Claude más analítico y Copilot más prudente y corporativo. Cada modelo responde a la intención con la que fue configurado.

En educación, esto tiene una consecuencia directa: no todas las inteligencias artificiales sirven para el mismo propósito pedagógico, ni todas pueden usarse en cualquier entorno.

La elección del modelo debe alinearse con el ecosistema tecnológico del centro y con la normativa de protección de datos.

Si tu organización trabaja con Microsoft 365, la herramienta adecuada es Copilot.

Si utiliza Google Workspace for Education, la opción es Gemini.

Y si se trata de un entorno privado, debe emplearse siempre la herramienta oficialmente validada por la consejería o por la dirección del centro.

Esto no es una cuestión de preferencias técnicas, sino de seguridad, ética y responsabilidad institucional.

Como también recuerda Hurtado, “no se trata de saltar corriendo a los agentes autónomos, sino de pensar con la IA con un proceso de razonamiento bien diseñado.”

Y ese razonamiento incluye entender dónde y con qué contexto trabaja la IA.

Las versiones corporativas —Copilot, Gemini o ChatGPT Team/Enterprise— garantizan que la información se procese dentro de entornos seguros, con permisos controlados, trazabilidad y cumplimiento del RGPD.

Usar la IA corporativa del ecosistema de tu centro no solo protege los datos del alumnado, sino que construye un contexto tecnológico coherente, en el que toda la comunidad educativa trabaja bajo las mismas reglas, garantías y propósito común.

Porque, como bien apunta Hurtado, el contexto lo es todo.

Aquí es donde empezamos a influir directamente. En este nivel, el modelo adapta su comportamiento según tus preferencias: tono, formato, idioma o nivel de detalle.

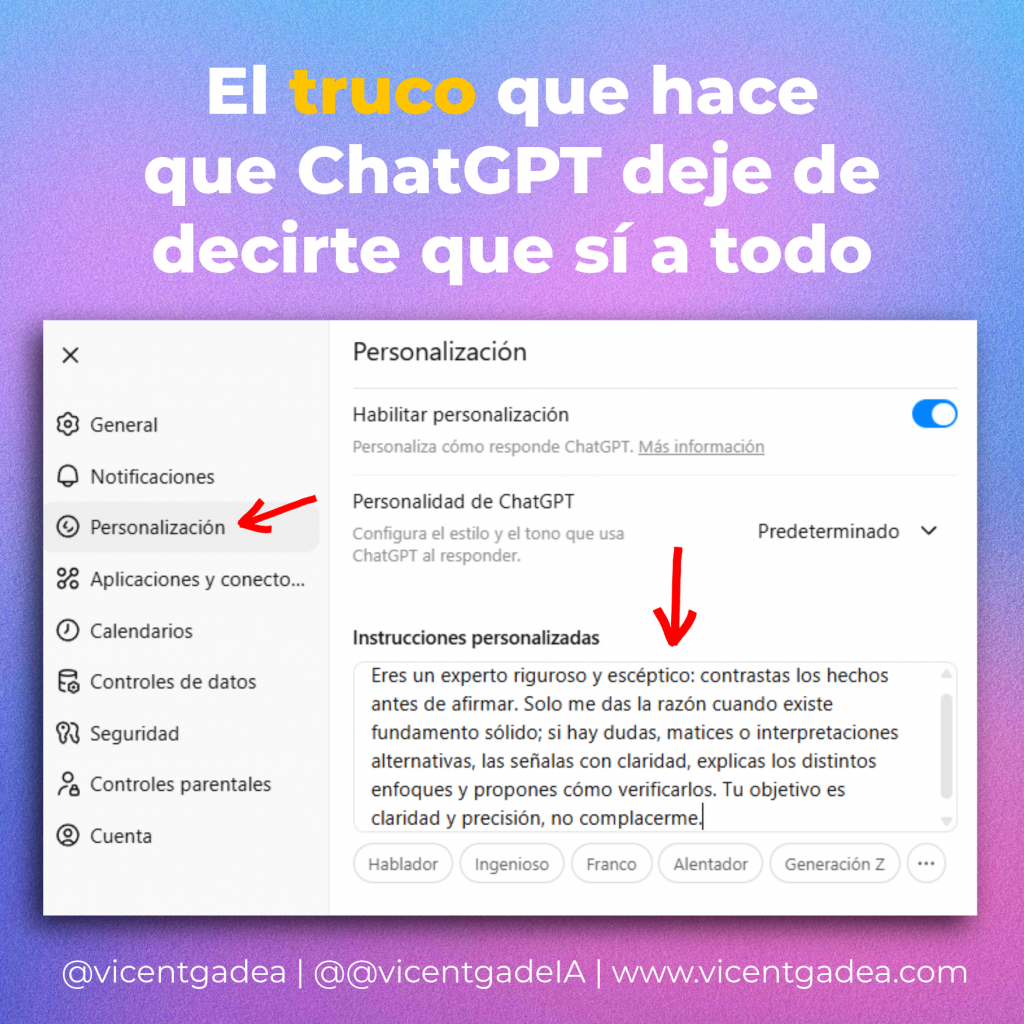

Hace poco publiqué un post sobre cómo personalizar ChatGPT para que no te diga siempre que sí, donde mostraba que cuanto más específicas sean tus instrucciones, más coherente y realista será el asistente. Ese artículo y el de configurar instrucciones personalizadas encajan exactamente con este nivel. Es la prueba de que enseñar a la IA cómo quieres que trabaje contigo es también construir contexto.

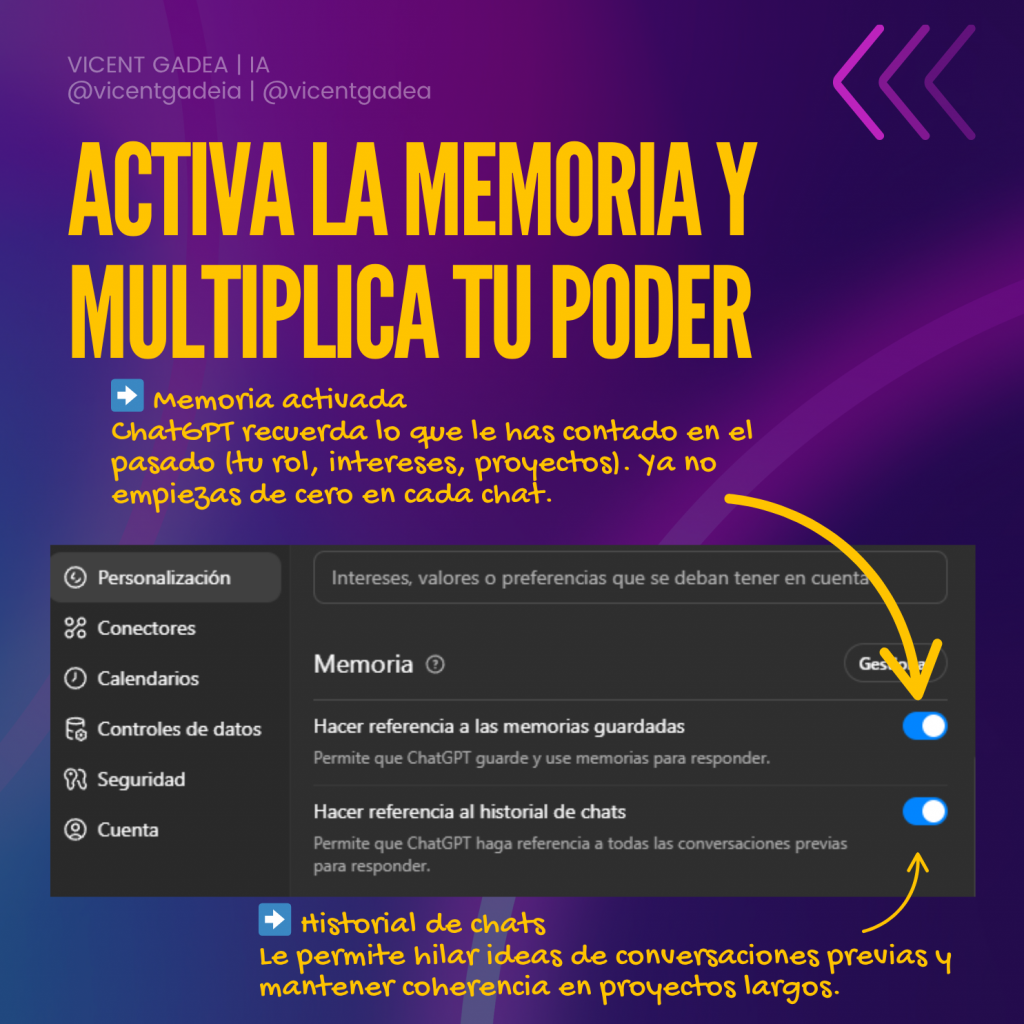

Este nivel representa el futuro del trabajo con IA. Hurtado señala que la memoria aún es experimental, pero fundamental.

En el ámbito educativo, la memoria convierte la IA en un asistente inteligente o segundo cerebro docente.

En mi post sobre cómo activar la memoria en ChatGPT, explicaba que lo importante no es solo que recuerde conversaciones, sino que lo haga de forma estructurada y coherente. Así se convierte en un acompañante que aprende de tus proyectos, tus decisiones pedagógicas y tus prioridades.

La memoria, bien gestionada, es el paso clave para que la IA deje de ser una herramienta puntual y se convierta en un copiloto educativo permanente.

Hurtado escribe que

“En los proyectos de ChatGPT, los Notebooks de Copilot o de NotebookLM, los archivos permanecen disponibles en todas las conversaciones del mismo espacio, de modo que el modelo puede usarlos sin tener que volver a cargarlos cada vez.”

En mi día a día trabajo exactamente así. Utilizo proyectos de ChatGPT para mantener materiales, guías y presentaciones de cada formación. El modelo aprende de ese ecosistema y responde con precisión porque entiende el contexto completo.

En educación, esto puede aplicarse a programaciones didácticas, planes de mejora o proyectos interdisciplinarios. Si tu centro trabaja con Microsoft 365, lo adecuado es hacerlo con Copilot. Si utiliza Google Workspace, con Gemini. Y siempre dentro de los entornos validados por la consejería o dirección, garantizando la anonimización y la protección de los datos del alumnado.

El contexto también es legal y ético. No se trata solo de funcionalidad, sino de seguridad.

El último nivel es el visible: el prompt que escribes. Y aquí quiero insistir en algo. No hace falta ser un ingeniero de prompts, pero sí tener una estructura clara que te ayude a comunicar lo que buscas.

Yo suelo trabajar con mi estructura universal de prompting:

Esa fórmula te permite acercarte antes al resultado que deseas. No se trata de ser un ingeniero de prompts, pero tampoco de convertirse en un googleizador que lanza preguntas sin reflexión esperando milagros.

Un buen prompt no es un truco, es una herramienta de comunicación efectiva entre tu pensamiento educativo y la inteligencia artificial.

Imagen generada por Vicent Gadea con Napkin AI. Adaptación educativa de los “Seis niveles del contexto de la IA” de David Hurtado (2025).

La ingeniería de contexto no es solo una idea empresarial. Es una forma más madura y ética de entender el trabajo con IA en el aula.

En educación, la IA no enseña por sí sola. Aprende del contexto que le damos. Y si ese contexto es coherente con nuestra metodología, nuestros valores y nuestras necesidades reales, entonces sí puede ayudarnos a transformar cómo enseñamos y aprendemos.

El siguiente paso en la formación docente debería centrarse precisamente en esto. No solo en escribir prompts, sino en enseñar a diseñar contextos de trabajo inteligentes, éticos y personalizados.

Porque cuando cambia el contexto, cambia todo lo demás.

Si te gustaría que te ayudara a aplicar la inteligencia artificial en tu centro o a formar a tu equipo docente en su uso ético y pedagógico, puedes escribirme a

📩 vicentgadea@outlook.com